Fig.1 Diagram of real-time IP system.

Abstarct

The Integral Photography (IP), which is one of the ideal 3-D photographic technologies, can be regarded as a method of capturing and displaying light rays passing through a plane. The NHK Science and Technical Research Laboratories have developed a real-time full-color IP system using a HDTV camera and an optical fiber array. In this paper, the authors propose a method of synthesizing arbitrary views from IP images. This is a kind of image-based rendering system, and is based on the 4-D data space representation of light rays. Experimental results show the possibility to improve the quality of rendered images by the computer graphics techniques.

CG技術において,より写実的な映像合成を目的として,

実写画像を積極的に用いる手法が注目を集めている[1].筆者らはこれまで,

光線情報に基づく空間記述方式の立場から,この問題に取り組んできた[2].これは,

3次元ディスプレイ技術の考え方を応用することによって,

リアルな3次元CGを実現しようとするものである.

本研究では,3次元画像技術の一つである,

インテグラルフォトグラフィ(Integral Photography; IP)に着目する.

従来のIP技術は,写真技術の一種であったが,

NHK技研によってハイビジョンを利用したメディア技術としての有効性が明らかにされつつある[3,4].

そこで本論文では,ハイビジョンカメラで撮影されたIP画像を入力として,

様々な視点位置における画像をインタラクティブに合成描画するシステムを提案・実装し,

その有効性について検討する.

ホログラムなどの3次元ディスプレイは,

ディスプレイ平面を通過する光線を記録・再現するデバイスであると考えられる.

3次元空間中のある平面を通過する光線は,その平面上での通過位置(x, y)と,

方向(θ, φ)をインデックスとする,

4次元の情報空間f(x, y, θ, φ)に格納される.

この4次元情報空間が得られれば,ホログラムなどを眺めているのと同様の感覚で,

様々な視点位置における像を計算合成することが可能となる[2].しかし実際には,

この4次元情報空間を効率的に得る(空間の光線情報をサンプリングする)ことが困難であるため,

撮像系の工夫や,光線情報の補間などの技術が必要になってくる.

筆者らはこれまでに,入力から画像合成までを実時間で実現するシステムとして,

Video-Based Renderingシステムを提案・実装してきた[5].

IPは,観察時に特別な眼鏡を必要とせず,任意方向への連続的な視点移動が可能であるため,

理想的な3次元ディスプレイ技術の一つであると言われている.原理的には,

多眼での同時撮影・表示を実現する光学系として,蝿の目レンズを用いる点に特徴がある.

蝿の目レンズは,小さなレンズの集合であり,各レンズは,

その中心を通る光束を要素画像として結像させる.

別の言い方をすれば,各レンズの位置(x,y)における各方向の光線を

要素画像(θ, φ)として記録・再生する技術であり,

先に述べた4次元情報空間の理論と整合性の高いシステムであることが分かる.

NHK技研では,屈折率分布レンズとハイビジョンカメラを用いた,

実時間フルカラーIPシステムを実現している[3,4].その構成をFig.1に示す.

Fig.1 Diagram of real-time IP system.

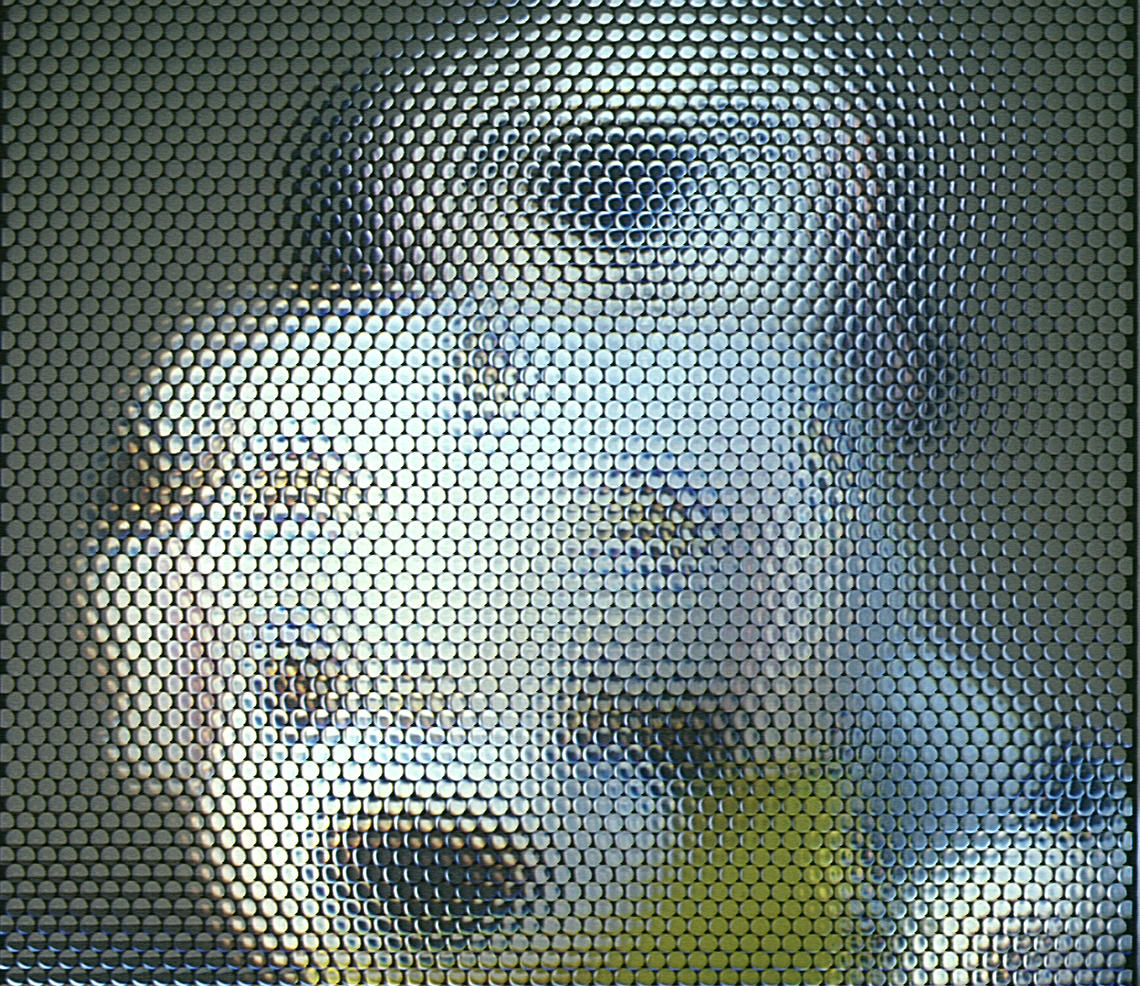

撮影側の蝿の目レンズに相当するのが,屈折率分布レンズ(光ファイバの束)であり, 表示側のそれは液晶ディスプレイに設置されたレンズ列である.屈折率分布レンズの利用により, 偽像や干渉の問題を解決している.詳細は文献[3,4,6,7]を参照されたい. ハイビジョンカメラには,被写体の倒立実像が,要素画像として, レンズ(光ファイバ)の数だけ写し込まれる.その例を,Fig.2に示す.

Fig.2 Captured IP image.

この映像を液晶ディスプレイで表示すると,液晶に設置されたマイクロレンズ列の働きにより, 観察者の位置に応じて像の見え方が変化する3次元ディスプレイとして機能する. 本論文では,Fig.2のような画像をコンピュータに取り込み, 特殊な光学系を用いることなく, インタラクティブに観察者の位置に応じた像を合成するシステムについて検討する.

| 手法 | 眼数 | 要素画像の解像度 |

|---|---|---|

| VBR[5] | 4×4 | 約180×120 |

| IP(提案手法) | 54×57 | 約20×20 |

Fig.2のような入力画像に対して,各要素画像の中心位置と大きさについて, あらかじめ位置あわせを行なっておく.本論文では,横に54列,縦に57行の要素画像を利用する. 多眼の同時撮影システムとして,先に提案したVBR[5]との比較をTable.1にまとめる. VBRに対して,要素画像の解像度を落として眼数を増やしたシステムとして, 本提案システムを位置付けることができる. なお,VBRの場合にはD1の映像信号を実時間で処理して画像合成を行なうことが可能であったが, 本提案システムでは,ハイビジョン信号を扱うため, 入力部分で実時間性を実現できていないという点が異なる.

まず,NHK技研のシステムにおける再生系と同等の画像を,計算合成することを考える. ここでは簡単のため,マイクロレンズ列において,各レンズに1つの色を対応させる (対応する要素画像から1画素を選択する)ことにする.これを「方式1」と呼ぶ. レンズ中心を通る光は屈折しないと仮定することにより, この画素選択は以下のように定式化される.すなわち, Fig.3のようにXYZ座標系を定義し,ディスプレイをZ=0, 視点位置を(x0,y0,z0) ,要素画像の中心位置を(x,y,0), ディスプレイとマイクロレンズ列とのZ方向の距離をdとすると, レンズを通して見える要素画像の位置(xe,ye)は以下で与えられる.

xe = x + d (x - x0) / (z0 - d) ‥‥(1)

ye = y + d (y - y0) / (z0 - d) ‥‥(2)

Fig.3 Coordinate system.

上記手法により,1つのレンズに1色を対応させた画像の再生が可能になる.ここで,

隣接する3つのレンズの間で色を線形補間することにより,

より滑らかな画像を合成することができる.これを「方式2」と呼ぶ.しかし,線形補間では,

必ずしも画質の向上を望むことは難しい.

そこでさらに,被写体の奥行きを仮定することにより,精度の高い補間を実現する.

これを「方式3」と呼ぶ.

Fig.4 Principle of interporation.

ここでは,Fig.4に示すように,被写体形状をディスプレイ(Z=0) に平行な面S (Z=zS)で近似することを考える. 視点A (x0,z0)からm番目のレンズの中心(xm, d)に引いた直線 がSと交わる点をQとする.点Qは,m+1番目の要素画像にも写っており, その画素の位置(qm+1, 0)は,m+1番目のレンズ中心(xm+1, d)からQに引いた 直線とディスプレイの交わる位置である.このとき,以下の関係式が導かれる.

qm = xm +

d (xm - x0) / (z0 - d)‥‥(3)

qm+1 - qm =

- zS (xm+1 - xm) / (d - zS)‥‥(4)

m番目の要素画像をIm,Im上の位置qmの画素を Im(qm)と表記すると, 「方式1」では,点QをIm(qm)で, 点RをIm+1(rm+1) で描き出し, QとRの間の補間は行っていない. 「方式2」では,QとRの間のテクスチャをIm(qm)と Im+1(rm+1)の線形補間で 補っている.これに対して,「方式3」では,QとRの間のテクスチャとして, Im+1の部分画像Im+1(x) (qm+1<= x <= rm+1) が利用可能である. 同じくIm(x) (qm<= x <= rm)も利用可能であるから, 各要素画像の適切な部分を適宜重み付けしてQとRの間のテクスチャを合成することができる. アルファブレンディング技術により,実時間でのテクスチャ合成が可能になる.

Fig.2を原画像として「方法1」を適用した結果をFig.5に, 「方法2」の結果をFig.6に示す. 「方法1」に比べて,「方法2」の方が滑らかな画像を合成できているが, 全体にぼやけた印象となり,必ずしも画質が向上しているとは言えない.

「方法3」の結果をFig.7に示す.上段は後ろの犬に, 下段は手前の犬に奥行きパラメータzSをあわせてある.zSは, 合成画像を見ながらインタラクティブに設定できるGUIを作成して利用した. 物体の奥行きに応じて,部分的に画質を向上させることができている. 方式の性格上,仮定した奥行きから離れた物体ほど,画質が悪化する傾向も見て取れる.

異なる原画像に対する結果をFig.8,9に示す. キラキラと複雑に反射する物体をポリゴンモデルで描き出すことは容易でなく, Fig.8によってイメージベースである提案手法の有効性が示されている. また,人物のように動く被写体をイメージベースの手法で描くには, 多眼撮像系による同時撮影が必須であるから,Fig.9は IP画像利用の有効性を示す結果である.

Fig.8 result of reflective object.

IP画像を利用したインタラクティブな3次元CGの合成手法について提案し,システムを実装した. 特殊な光学系で3次元像を再生する場合に比べて, コンピュータによる複雑な処理を加えることにより,画質を改善する手法について検討した. 現在のシステムでは,ハイビジョン映像を実時間で入力することができず, 静止した空間が処理の対象になっているが, 今後は動画像入力の実現に向けた検討を進める予定である.

本研究で用いたIP画像は,湯山一郎氏,岡野文男氏,星野春男氏, 洗井淳氏のご厚意によりNHK放送技術研究所にて撮影させて頂いたものである. ここに感謝の意を表する.